Entendiendo los Modelos IA

En el pasado, construir un modelo de generación de texto desde cero requería un entrenamiento exhaustivo durante varios meses. Sin embargo, el panorama de la IA ha evolucionado considerablemente.

Los modelos GPT (Generative Pre-trained Transformer) están preentrenados con información de toda la web, lo que resulta excelente para chatbots de propósito general como ChatGPT. Estos modelos responden bien a las preguntas cuando la respuesta está implícita de algún modo en los datos de entrenamiento.

En el caso de ChatGPT estos datos estaban actualizados hasta 2021, y el propio modelo así lo hace constar cuando se le somete a ciertas consulta. ChatGPT es lo que podríamos llamar un modelo base, que puede ser personalizado con más entrenamiento con herramientas como el proceso de fine-tuning.

El papel del fine-tuning

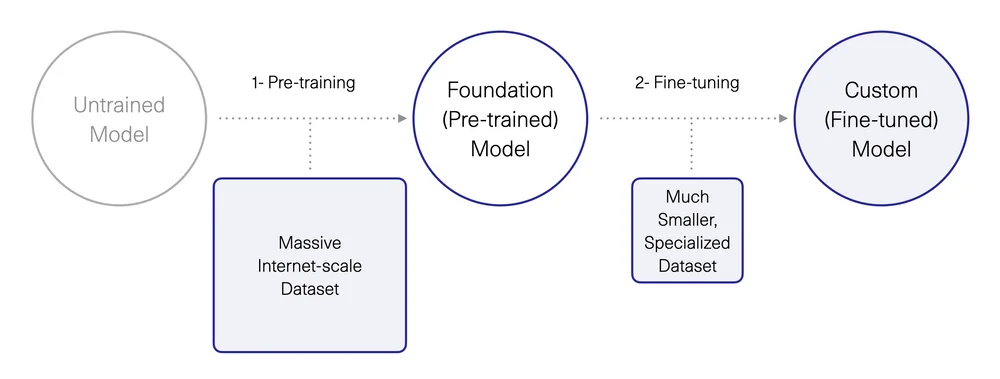

Conceptos como “modelo base” y “modelo afinado” son clave para entender cómo funciona la IA generativa. Los conceptos clave para entender los. A partir de un modelo base preentrenado es posible mejorar sus capacidades afinándolo con un conjunto de datos más pequeño, perfeccionando su rendimiento para una tarea específica.

El problema surge cuando el modelo (diseñado para generar contenidos) desconoce la respuesta que debe generar. Es entonces cuando nos encontramos con las llamadas “alucinaciones”. Ocurre con información muy específica del sector o de la empresa. El modelo inventa una respuesta porque su función principal es la generación de contenidos, no proporcionar información precisa.

El proceso de fine-tuning tiene valor económico, ya que permite a las empresas crear modelos propios personalizados, incluso si el modelo original era de acceso público o de código abierto.

Para quienes operan en la capa de aplicación, la incorporación de modelos personalizados con fine-tuning puede ser un factor diferenciador. Además, proveedores como ChatGPT ya permiten experimentar cómodamente con modelos personalizados.

Embeddings: Una Nueva Capa de Información

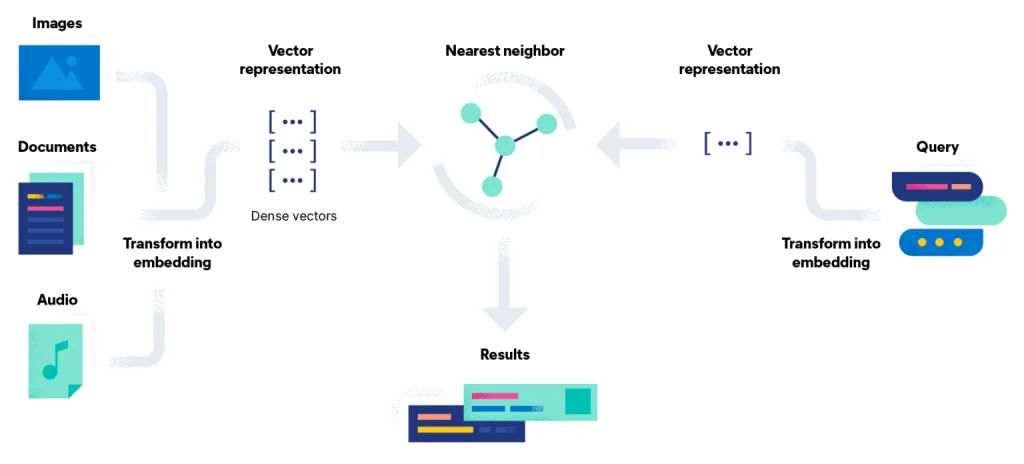

Los embeddings sirven como una capa adicional de información que añadimos al modelo para gestionar consultas específicas. En estos casos OpenAI recomienda el entrenamiento con “embeddings“, para lo que han lanzado una API específica.

Con esta API creamos un índice que contiene información relevante, buscamos secciones en ese documento similares a la consulta del usuario y creamos una nueva consulta con esta información para responder a la pregunta.

Los casos de uso de embeddings son múltiples: Asistentes de IA de atención al cliente que responden a las preguntas más frecuentes, bots de programación que responden a las preguntas de los desarrolladores, bots de respuesta a preguntas jurídicas que ofrecen respuestas precisas a consultas legales, bots de respuesta a preguntas médicas que responden a las consultas de los pacientes, preguntas sobre los puntos clave tratados en una reunión, etc.

Conclusión

Podemos utilizar el fine-tuning para el entrenamiento necesario para personalizar aspectos más generales, como el estilo de comunicación o el uso de vocabulario. Esto implica 3 capas de modelos: preentrenado, ajuste fino e incrustaciones (algo que veremos en un post más adelante).

De esta forma, empresas como HAL149 aprovechan los modelos básicos existentes y los adaptan a requisitos específicos para dar a sus clientes una ventaja competitiva.